Это гостевая статья в блоге, про нейросети. Ребята представятся сами, я просто даю площадку для общения. Если вам тоже есть чем поделиться, пишите свои идеи прямо мне в личку @denominant

На примере ютуб-канала Level One я покажу суть работы с нейросетями, которые генерируют изображения и делают анимации. C сентября 2023-го по июль 2024-го мы еженедельно выпускали видео, которые окартинивали с помощью ИИ. Есть что рассказать.

Главное, что кнопки «сделай красиво» — нет. Чтобы было не абы как — надо заморочиться. Даже с Sora (это та самая нейронка, которая обещает супер-пупер-мегареалистичные видео выдавать).

Мы заходили в проект со слабым представлением о том, как получать классный результат от нейросеток. В моём инфополе были настроения, мол «вау что творят нейронки», каждый день валились новости про запустили такую-сякую нейронку, нейронки научились тому-то и прочее. Поэтому было любопытно попробовать.

Обращаю ваше внимание: да, за год технология генераций изображений и видео стала лучше. История не про это. Мы показываем какой надо пройти путь…

—> от «взбрело в голову, что будет круто окартинивать видео нейросетями»

—> до «реально внедрить нейросетки в ежедневную работу продакшна, и использовать их как надо (хотя бы на 50%)».

Я Илья Мелехин — глава креативной команды «Нидл», мы делаем контент, который продвигается органически. Работаем со смыслами и психологией зрителя. Рекламный бюджет в 90% наших кейсов — 0 рублей. Канал для онлайн-лектория Level One мы как раз подняли без интеграций у блогеров, а только за счёт оригинального формата для видео. Картинки от нейросеток также сыграли свою роль.

Контекст проекта

Как у ютуб-канала для Level One появились нейросети? Генерации были обоснованы концептом.

Опираясь на возможности и задачи заказчика, мы придумали, что будем делать а-ля научно-популярный сериал. Выбираем одну тему на сезон, а лекторы Level One раскрывают её с разных сторон. Один сезон — один месяц, новая серия — каждый четверг. Первая тема — КОНЕЦ ЧЕЛОВЕЧЕСТВА.

Если вам интересно, как создаётся контент, который продвигается органически, то в конце этой статьи я дал ссылку, где подробно описывается, как мы пришли к идее формата для Level One и как сработала эта стратегия (спойлер: отлично). А нас интересуют нейросети.

Итак, научпоп-сериал. Мы подумали: раз сериал, то и визуал должен быть киношным. Дорогую картинку мы позволить себе не могли. Из киношного мы сделали атмосферные заставки в начале ролика под классную музыку, которую для нас написал знакомый композитор.

Начало это хорошо, но чем перекрывать видео с говорящей головой в 30-40 и более минут?

Денег на графику или там иллюстратора, естественно, нет. Даже если бы и были, то выход еженедельный, ни один иллюстратор не успеет нужный объём. А темп важен. Приличные сервисы стоков — это оксюморон — вообще пользоваться шаблонными стоками 100 лет как дурной тон. Да мы пользуемся, но не “пластиковыми” if you know what I mean). Можно создавать динамику, перекрываясь картинкой из интернета. Но! Не во всех темах есть хорошая картинка. Плюс хочется выделиться. Одной красивой заставки мало. Я решил использовать нейросети.

В нашей команде был человек, который больше всех интересовался технологиями — Яан. Нейросетями он пользовалься тоже, но пока не глубоко. Я попросил его заняться процессами и внедрить историю с ИИ на канал. Уже через несколько дней он показал мне первые примеры и я, как стандартный бумер, был впечатлён.

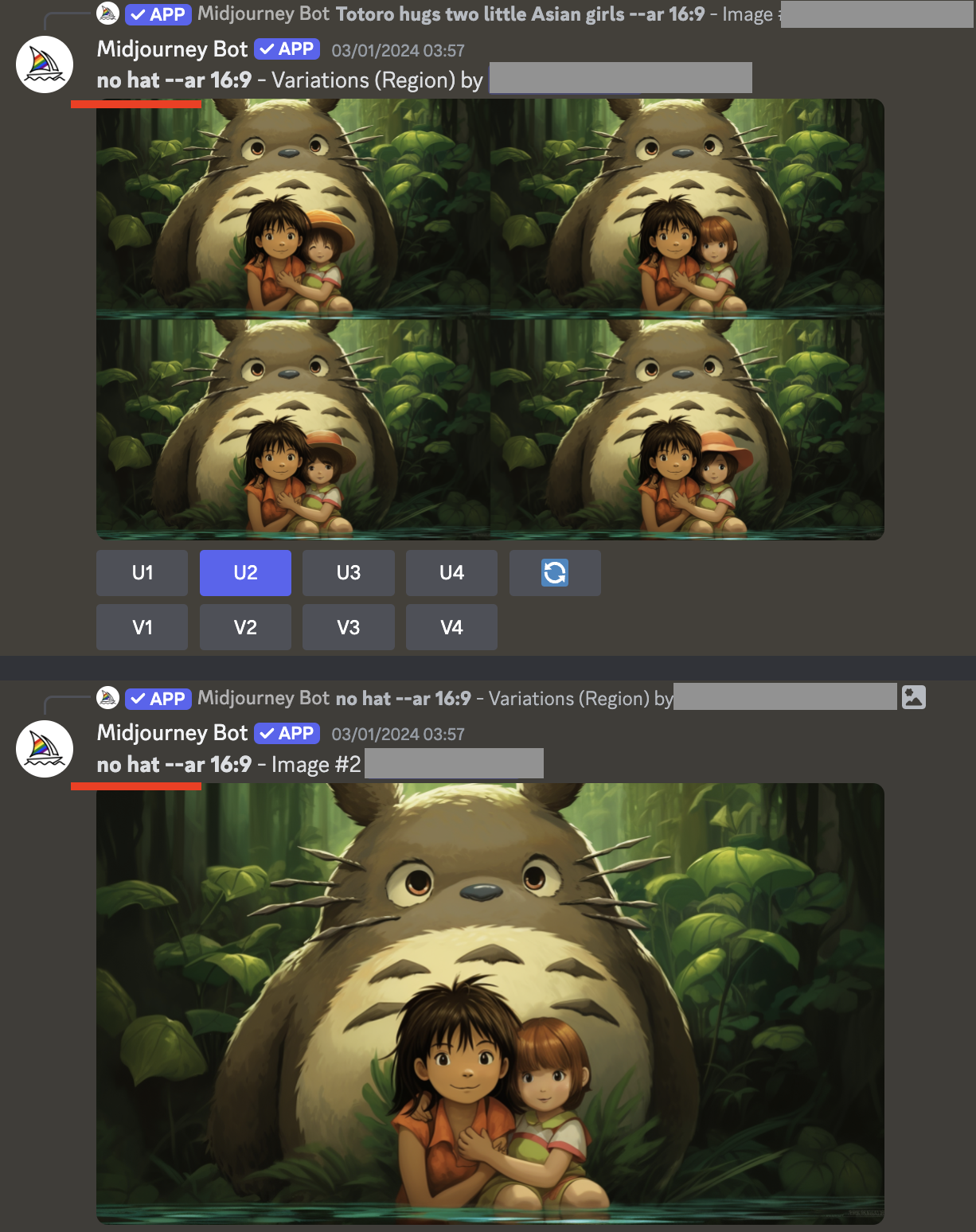

Скриншот из переписки Ильи и Яана

Перед запуском канала мы сформулировали такой подход — каждое включение нейрогенерации в ролике должно быть как маленькое кино. То есть, мы не просто лепим рандомные картинки, а нужно, чтобы кадры между собой как-то согласовывались, чтобы в них была история. Мы подумали, что такие сцены, сделанные нейронками, могут стать нашими viral hooks, то есть чем-то, что будет привлекать внимание, что будет хотеться рассматривать, а значит залипать на видео.

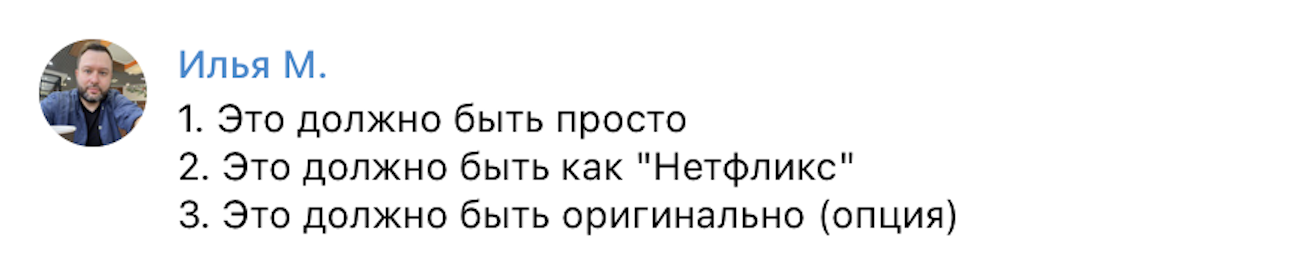

Оставалось понять, как это делать. Задачи я сформулировал так (см.скриншот):

Скриншот из переписки Ильи и Яана

Настройка производственной цепочки

Любая работа с нейронками — это как бросать кубики в казино. Ты будешь бросать кубики до тех пор, пока не получишь нужный тебе результат. А кубики эти шестигранные или тысяча двухсотгранные — это уже зависит от тебя. Ты работаешь с вероятностями

Яан Прокофьев, креативный продюсер ютуб-канала Level One, эксперт по работе с нейросетями

Главной задачей на старте для нас было разобраться, как получать от нейронок предсказуемый результат. То есть нам нужно было научиться производить небольшие сцены — по 3-4 кадра — и чтобы они были в одном стиле, разной крупности, чтобы если надо, повторялся персонаж или место, и так далее.

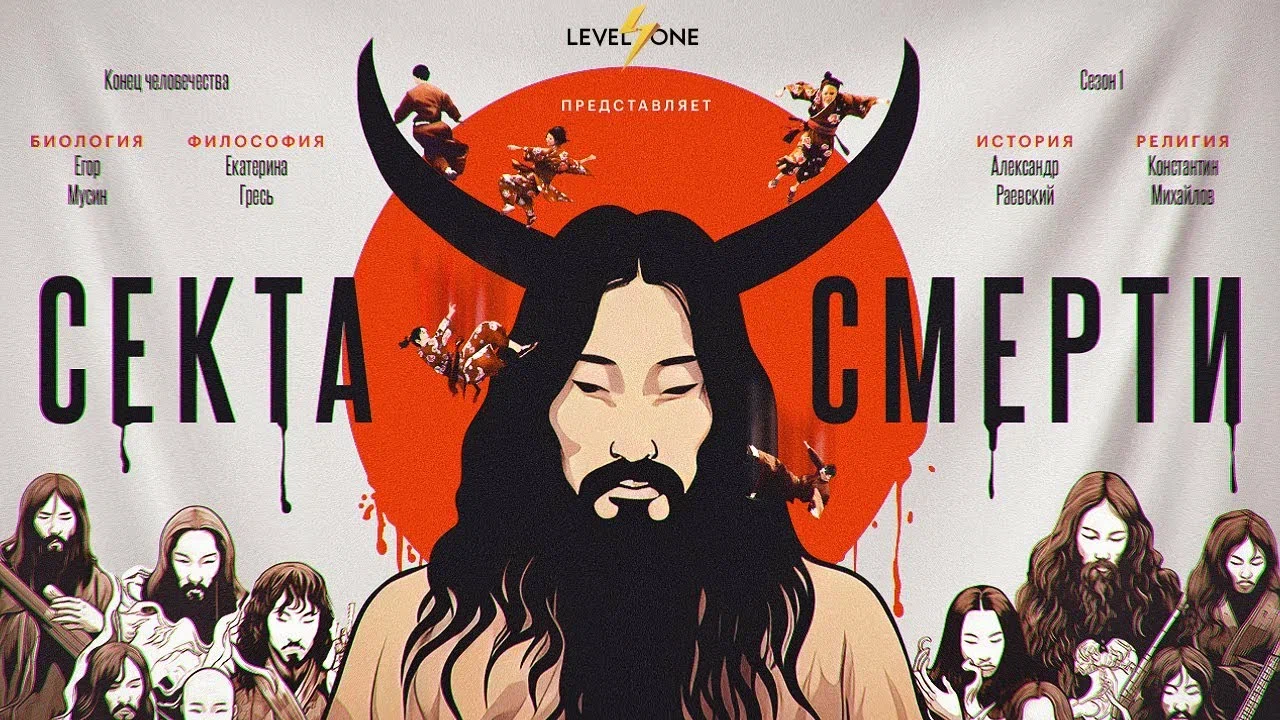

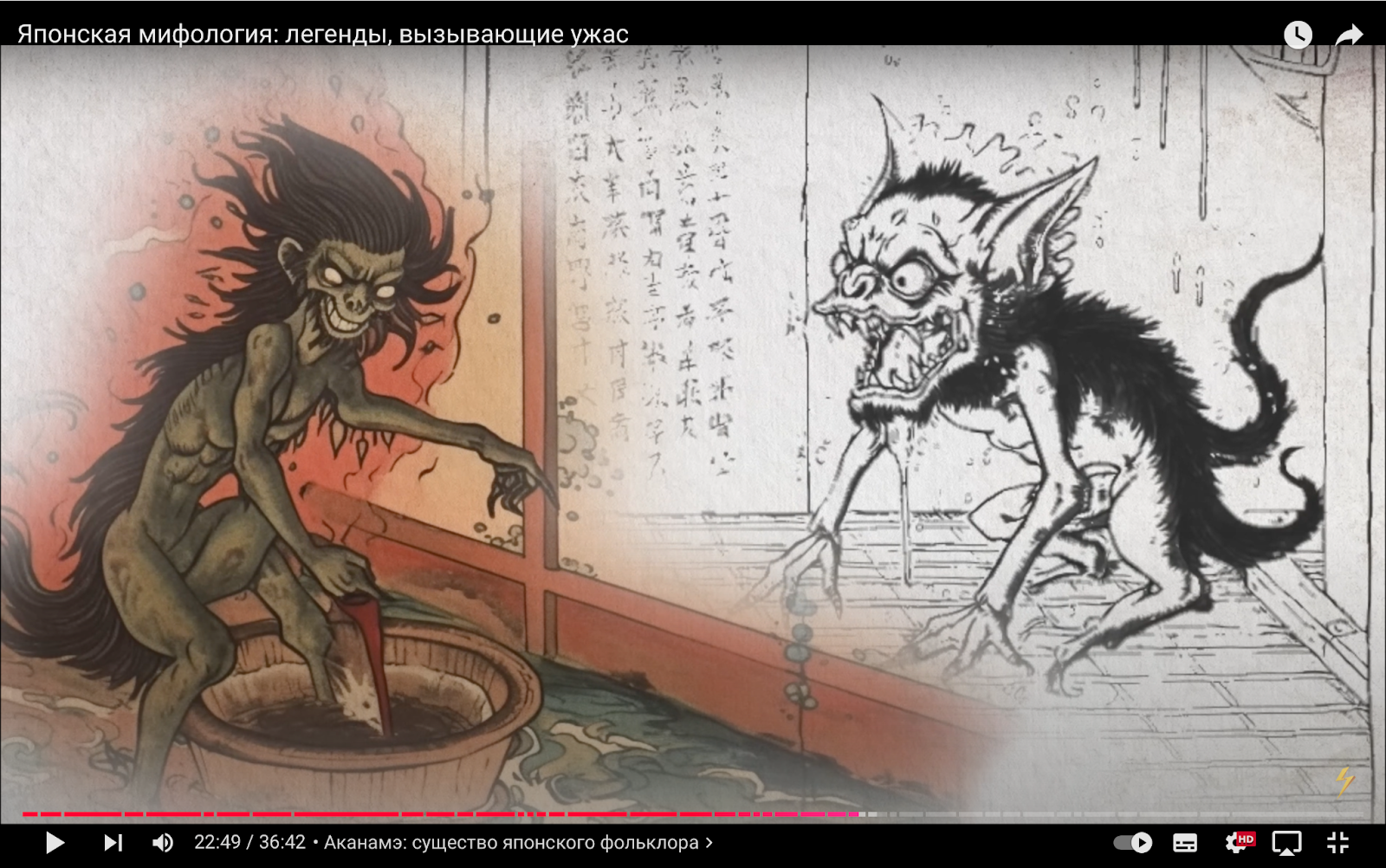

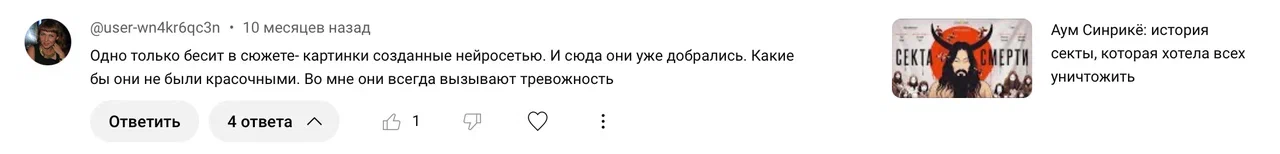

Забегу вперед и сразу покажу пример такой сцены. Это фрагмент из второго видео на канале про японскую секту Аум Сенрикё. Под эти кадры ведущий рассказывает, как террористы секты зашли в вагон токийского метро, и у них были пакеты с жидкостью, содержащей зарин — нервно-паралитический газ.

Фрагмент выше полностью сделан нейросетями: и картинки, и анимация. Монтажёр только склеил три куска видео. Есть несколько разных подходов, чтобы получить подобный результат:

Первый

- Сначала cгенерить картинку, например в Midjourney или Dall-E

- Затем анимировать её, например, с помощью Runway, Genmo, Leiapix и тд.

Второй

- Сразу генерить видео. Genmo, Runway и другие сервисы позволяют генерить по текстовому запросу.

Третий

- Это генерировать видео из видео. Например с помощью Runway video-to-video

На старте мы использовали все три способа, но в итоге остановились на первом. С нейросетками, которые сразу генерят видео, результаты не такие предсказуемые, как когда ты получил картинку и потом её анимируешь.

Плюс нам было важно держать темп — мы выходили каждую неделю с выпуском по 30 и более минут. Любой лишний хаос — помеха.

Для генераций картинок мы всей командой использовали Midjourney (далее буду писать Миджорни). Мы пробовали Dall-E, он привлекал тем, что принимал запросы на русском языке. Миджорни — полностью на английском. Но главный минус Dall-E — он не подходит для работы на потоке, у неё ограниченное количество генераций, даже в платной версии. Исчерпал — сиди жди три часа.

А для генерации видео мы остановились на Runway. В платной версии у них тоже неограниченное количество генераций.

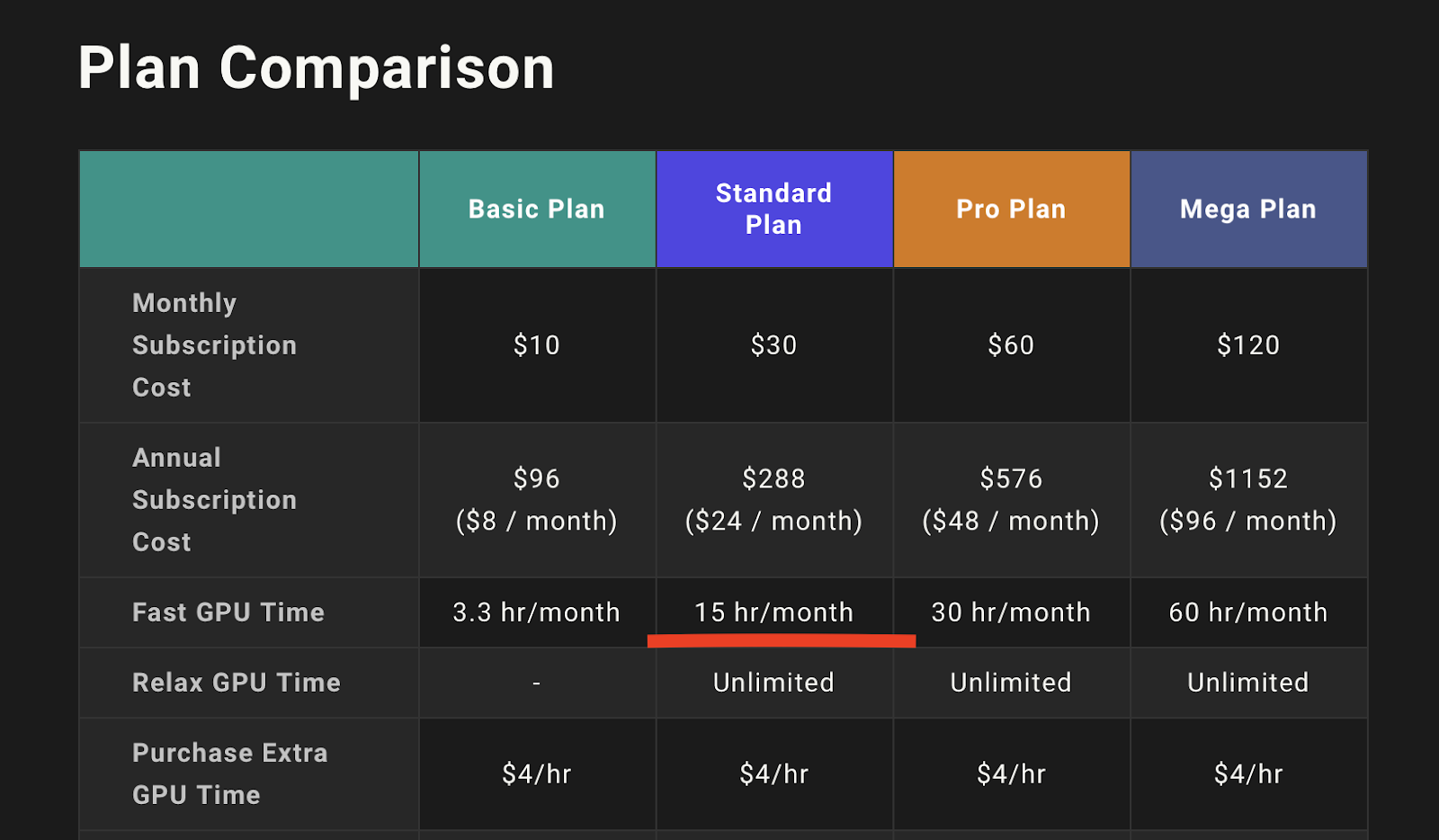

- Midjourney Standart plan с подпиской на год обошёлся нам в 288 долларов (24 доллара или около 2100 рублей в месяц)

- Runway для анимации обходился нам примерно в 110 долларов (10 тысяч рублей) в месяц.

А теперь поговорим про нюансы…

Время на генерации

Чего мы не учли в концепте, так это того, что нейронки делают генерации не моментально. Классно было бы, чтобы Миджорни выдавал тебе картинку по запросу так же быстро, как Гугл. Но это не так.

Помните про это, если планируете плотно работать с нейронками, которые генерят изображения.

Например, в Миджорни есть две скорости генерации — fast и slow (технари, не минусите за скудные объяснения, специально переводим на человеческий).

В среднем Миджорни генерит одну картинку по текстовому запросу в режиме slow (то есть обычном, базовом) — две, две с половиной минуты. Зависит от загрузки сервера. В режиме fast одна генерация занимает — 30-40 секунд.

Режим fast, к сожалению, небесконечный. Мы оплачивали годовую подписку, и по условиям годовой подписки — у нас было 15 часов fast генерации в месяц. Эти сладкие, быстрые часы мы сжигали в первые дни.

Скриншот, расценки у Миджорни

Runway же генерирует из картинки видео (добавляет движения людям или делает зум и тд) в среднем за минуту.

Для наглядности, сколько времени уходило на генерации, давайте примерно посчитаем на конкретном ролике. Я уже показывал сцену из него в начале этой части статьи. Это ролик про японскую секту, который собрал почти 2 млн просмотров. Он вышел на канале вторым.

Итак

- Общий хронометраж ролика — 57 минут

- Из них нейрогенерации занимают — 11 мин 55 сек

- Эти почти 12 минут видео состоят из 155 сгенерированных изображений

Считаем дальше (по средним значениям)

Одна картинка в Миджорни в обычном режиме генерится две, две с половиной минуты. Возьмём для расчётов минимальное значение — две минуты.

Чтобы получить от Миджорни то, что ты хочешь, нужно в среднем три попытки. То есть вот ты отправил промт, и сто процентов первый вариант тебя не устроит. Доработал промт — получил новый драфт. И так до победного. Нейросеть часто выдаёт чушь, чушь нам не нужна. Если достаточно приноровился к этому делу, то за три итерации нужное изображение ты получишь. Затем 2-3 драфта на апскейл, то есть на допилить тот вариант, что тебя в итоге устроил, и вывести его в полном разрешении. Итого: минимум пять генераций нужно до финального драфта, который пойдёт в ролик.

Для этого расчёта представим, что Runway сразу анимирует как надо, с первой попытки (в жизни так далеко не всегда).

Получается:

- В режиме slow на создание одного изображение в Миджорни уйдёт 10 минут

- На 155 ≈ 26 часов

- Чтобы анимировать 155 изображений в Runway — нужно 2 часа 30 минут

Итого, на создание почти 12 минут нейрогенераций для ролика про японскую секту смерти мы потратили минимум 28 часов 30 минут.

Чем сложнее была тема, тем больше времени уходило на генерацию. Например, Миджорни нормально справилась с темой про самураев. А вот для ролика про «Звездные войны» пришлось помучаться, ибо нейронка могла нарисовать сикха вместо джедая, а это сразу попадос у фанатов.

С темами, где нужна прямо тотальная точность, Миджорни не справлялась. Например, в ролике про динозавров нам знатно прилетело от увлекающихся темой. Это мы запомнили.

Важную вещь про Миджорни и в целом про нейронки, которые генерят изображения, круто сформулировал как раз Яан, который в проекте Level One ставил всю работу с ИИ:

Работа с нейронками – это как работа с троечниками в школе. Они тебе принесут, что ты хочешь, но это не будет жемчужиной, тебе в любом случае придётся это дорабатывать.

Яан Прокофьев, креативный продюсер ютуб-канала Level One, эксперт по работе с нейросетями

Конкретный пример из ролика «Почему человек (не) подчиняется законам физики?». Посмотрите на гифку ниже. Чтобы сделать эту простую, казалось бы, сцену редактору, которая генерировала картинки для неё, пришлось изрядно помучаться. Как думаете, с чем?

С машиной. Надо было, чтобы на трёх изображениях была одна и та же тачка. Сначала редактор указала в промте просто red car (про промты мы подробнее поговорим ниже). И на каждый запрос Миджорни выдавала красную машину, но разных моделей. Это главная сложность, если хочешь серию картинок с одинаковым предметом или одним и тем же человеком — нужно заморочиться. И результат всё равно не гарантирован.

В случае с красной машиной, наш редактор поняла, что надо уточнить модель. Но какую тачку точно знает Миджорни? Так как нейронка это троечник, она знает только вершки, поэтому нужно что-то максимально попсовое. Поэтому Фольксваген Жук. После такого уточнения Миджорни выдала изображения с одинаковыми авто.

Правда, не со всей попсой так работает. Например, Миджорни, как правило, очень криво изображает старые телефоны. Хотя, казалось бы, попсовый образ.

И таких нюансов куча. Все они влияют на время.

Ещё один важный фактор, который влияет на скорость продакшна — это то, что процесс генерации очень залипательный. Не раз я осознавал себя спустя два часа зависшим на первой картинке из списка. Особенно в начале было трудно оторваться и перейти к следующему изображению.

Командная работа

За первые пару месяцев работы у нас сложился чёткий воркфлоу, он же регламент, по созданию нейрогенераций для роликов.

Над одним роликом в неделю работали четыре человека. Два монтажёра. И два редактора.

Шаг 1. Раскадровка

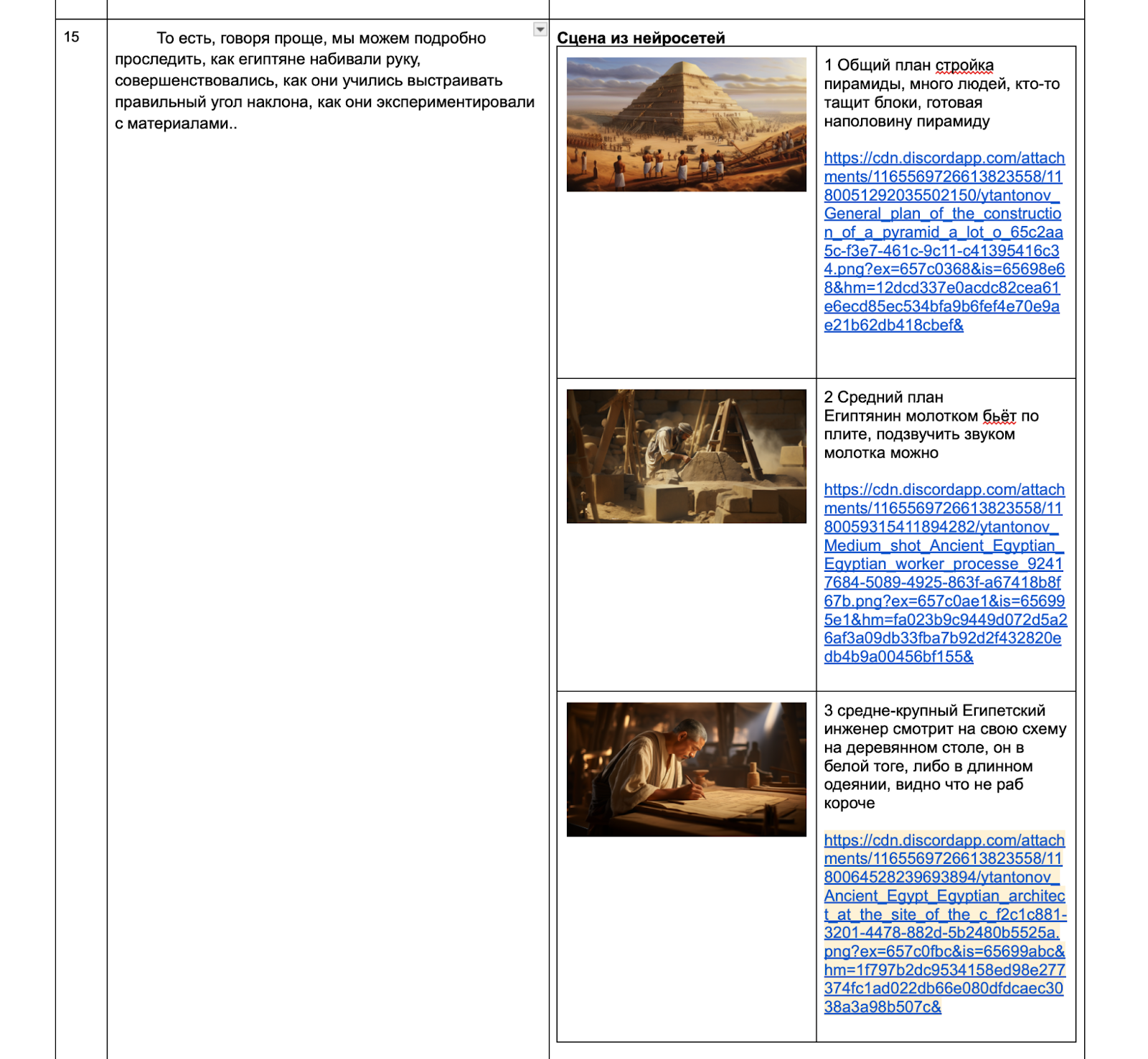

Сначала на стадии окартинивания редактор писал раскадровку для нейрогенерации. В среднем одна такая сцена — три кадра разной крупности.

Чуть уточню про термин окартинивание. Как мы работаем в сложных роликах. Сначала мы делаем «рыбу», то есть нарезаем исходники со съёмки, убираем лишние дубли, оговорки и прочее. То, что получилось, мы перегоняем через нейронку, которая делает расшифровку, и у нас получается дословный текст. Этот текст мы оформляем в специальный документ для монтажёров. Там редактор пишет, что куда поставить в видео и чем перекрыть конкретный фрагмент.

Вот так выглядела типичная раскадровка сцены с нейронками в сценарии для Level One.

Чаще всего мы показывали генерации на фрагментах, где лектор говорил что-то образное. И задача редактора была придумать какую-то небанальную сцену. Мы в команде в принципе считаем, что высший пилотаж — это когда сделано не в лоб, то есть картинка не дублирует речь, а дополняет. Но понятно, что если человек показывает математические расчёты, то надо показывать расчеты.

В какой-то момент Яан решил упростить жизнь редакторам (и себе, конечно) и попробовал ChatGPT. Яан рассказал ИИ, как делать раскадровки, расписывать визуал. Затем скармливал ей куски текста по 3-4 абзаца.

Первоначально всё это было лютым ужасом, всё это приходилось выкидывать в унитаз. Начиная с энной попытки, когда я ему говорил, что типа давай теперь здесь не так, а вот так, тут давай по-другому и так далее, он (ChatGPT) начал всё-таки респондить нормально.

Яан Прокофьев, креативный продюсер ютуб-канала Level One, эксперт по работе с нейросетями

Да, не очень креативно, но по смыслу приемлемо.

В общем, окартинивание с помощью ChatGPT в команде не прижилось. Креатив у ИИ пока на хилую троечку.

Шаг 2. Генерация изображений

После раскадровки ребята, как они говорили, «уходили на генерации». Выше вы уже видели расчеты и поняли, что это процесс небыстрый, так что минимум на день человек пропадал с этой задачей. Генерили в Миджорни у нас все, и редакторы, и монтажёры. Каждый учился писать промты. Обычно всё для монтажа у нас по максимуму ищут и готовят редакторы. Но в этом случае выхода не было, мы подключили к генерациям и монтажёров, иначе мы бы не успевали. Дедлайн из зе кинг.

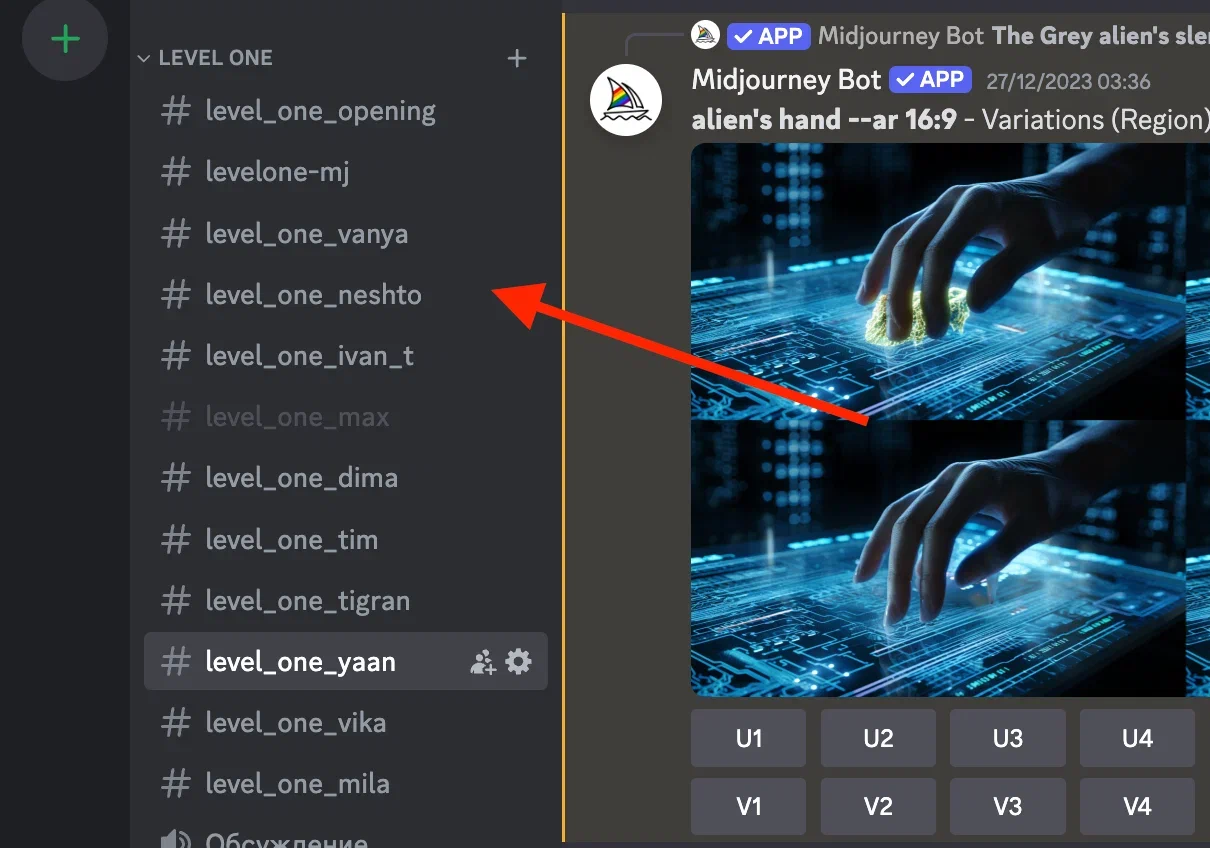

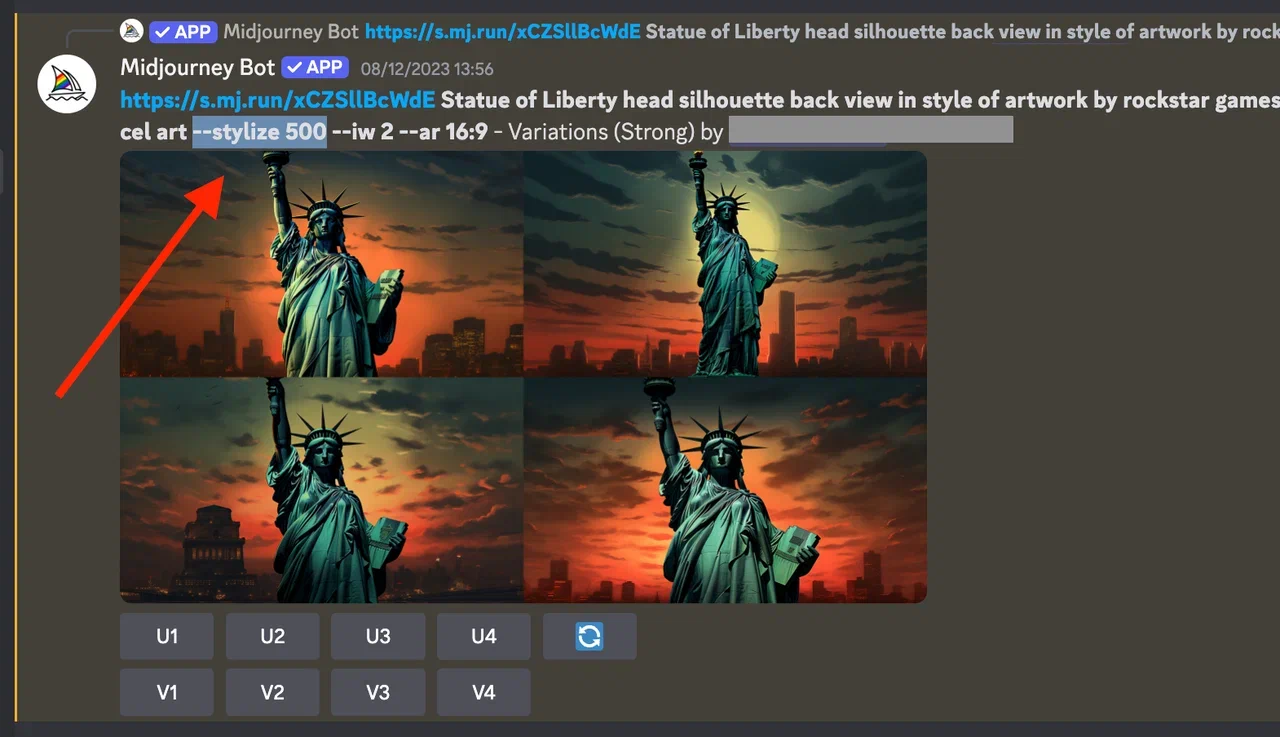

На скриншоте ниже вы можете увидеть как выглядела папка в Discord под генерации для Level One. У каждого, кто работал над проектом (редактора, монтажёра, дизайнера превью) своя ветка под генерации.

Кстати, Яан пробовал делегировать ChatGPT и написание промтов. Но с этим ИИ тоже не справился.

Я скормил ChatGPT все материалы, как правильно писать промпт. Он их не воспринял, поэтому мы с ним пришли к тому, что он просто давал текстовое описание на английском всей этой сцены, а я уже дальше его дошлифовывал, вставлял параметры для того, чтобы получать нужную картинку

Шаг 3. Анимация изображений

Ну тут всё понятно. Картинки из Миджорни прогонялись через Runway и анимировались. Это тоже умели делали все члены команды.

Шаг 4. Монтаж

На монтаже уже ребята склеивали три куска видео из Runway, и получалась сцена. Кроме нейрогенераций в роликах были и стандартная инфографика, и фото, и видео. Но вот на нейронки уходило больше всего времени.

Чтобы этот воркфлоу работал нормально, удавалось держать темп и даже повышать качество, Яан сначала учился сам, а затем проводил обучение для команды.

Например, Яан искал, как сократить время работы в Миджорни. Все, кто работали с Миджорни, знают, что нужно совершить много телодвижений, чтобы тупо сохранить итоговую картинку. В ситуации, когда у тебя каждая минута на счету — это отстой. И вот, например, хорошей штукой для ребят стал плагин для Chrome, который позволял в веб-версии дискорда скачать итоговую картинку не за четыре клика, а за один.

Яан следил за апдейтами и быстро вводил их в работу. Это тоже экономило время. Например, важным обновлением в Миджорни стала функция, которая позволяла дорабатывать отдельные области в изображении. То есть можно было перебрасывать уже не все кубики, а только один, который отвечает за одну конкретную область.

Потом в какой-то момент Runway апдейтнулся, и у нас появилась возможность тоже не анимировать всю сцену целиком, а допустим только горение свечи. Ты выделяешь область, где свеча и всё. Это упрощало задачи

Также Яан находил учебные материалы по промтам, как они строятся. И это было самой большой частью обучения команды.

По промтам у команды в процессе работы над проектом создавался уже отдельный регламент. Регламент внутри регламента, да.

Работа с промтами

Правило 1. Хочешь получить классный результат, собери референсы заранее

За две недели, ещё когда был другой ролик в работе, мы начали собирать референсы. Это очень важная штука, потому что, если у тебя есть референсы, ты можешь их скормить нейронке как часть промта. Сейчас вообще есть команды, которые отсылают тебя к тому, что вот если ты дал чёткую картинку, он будет стараться делать конкретно, как вот эта картинка сделана.

До того как появилась возможность прямо «скармливать» Миджорни референсы, они в целом были для понимания, к какому результату команда хочет прийти. Ну, например, минимально в каком стиле делать генерации: гиперреалистичные или а-ля гравюры.

Когда ребята успевали погрузиться в тему ролика, а особенно когда тема им нравилась, генерации всегда выглядели круче. Пример — ролик про японскую мифологию, второй миллионник на канале. Но номер один по атмосфере.

Скриншот, пример кадра из ролика:

Правило 2. Не понимаешь, как объяснить нейронке задачу — спроси у неё

Часто приходилось сталкиваться с тем, что генерация не соответствовала тексту промта. Даже если ты предварительно скармливал Миджорни кучу картинок, слова, которые ты использовал, не давали нужного результата. Утрированный пример: попросил Миджорни нарисовать белого зайчика, а она нарисовала слона.

И тогда у нас в пайплайне появилась такая штука, как Describe. Если ты не понимаешь, что спросить у нейронки — покажи ей картинку, спроси, что она видит, и после этого заставь её генерить уже по её описанию, что она видит

Правило 3. Учи параметры

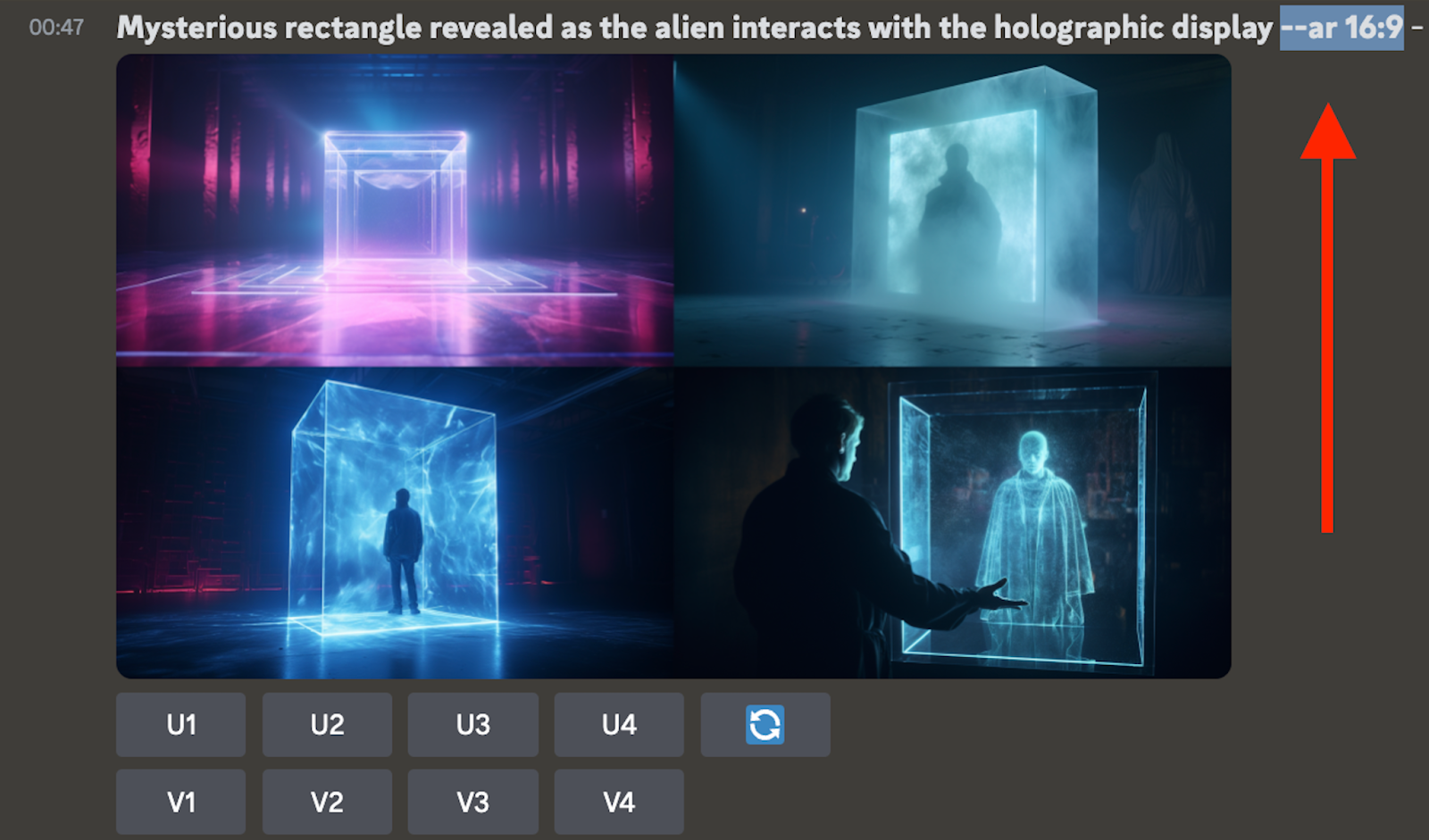

И вот мы подобрались к самой интересной штуке, которой надо учиться пользоваться, если ты хочешь работать с Миджорни, да и в принципе с нейронками, где есть промты. Параметры!

Текстовый запрос — это хорошо, но есть много параметров, которые позволяют улучшить качество получаемого результата. От выпуска к выпуску мы обрастали новыми параметрами, которые позволяли получать более четкие изображения.

Допустим, самый первый параметр, который мы ввели, был Aspect Ratio. Это чтобы картинка была не квадратная (что базово выдаёт Миджорни), а 16 на 9, как для кино. Пример:

Следующим мы ввели параметр стилизации. Насколько всё должно быть стилизовано в сцене, насколько что должно быть прорисовано.

Потом у нас добавился параметр хаос. Хаос нужен для того, чтобы ломать привычные паттерны, потому что в любом случае нейронка обучалась на каких-то материалах, и у нее есть паттерны. Допустим, если ты попросишь нейронку сгенерить какую-нибудь сцену из «Чужого», например, как у чувака из груди вылезает монстр, Миджорни тебе такую штуку не сделает, потому что у неё есть жёсткая привязка к физиологии человека. И он не может разломать скелет. А если ты вводишь параметры хаоса, то да, он может почудить. Для промта: —chaos.

Затем мы открыли для себя No. Это негативный промпт. Например, ты хочешь получить ковбоя без шляпы. Вот ты прописываешь типа, дай мне ковбоя, и он тебе ковбоя большую часть времени будет рисовать со шляпой. И ты такой, пишешь no hat, и всё, получается ковбой без шляпы.

И так далее. От выпуска к выпуску команда обрастала всё новыми параметрами, которые позволяли получать более четкие изображения.

Но даже несмотря на то, что в продакшне был человек, который следил за обновлениями нейронок (и в которых мы работали, и сёк поляну в целом), а также проводил обучающие созвоны, не все сразу схватывали, а тем более повторяли за ним какие-то сложные вещи.

Например, одна из самых сложных задач для Миджорни — это перерисовать какого-то реального человека или персонажа и выдать варианты, где этот человек/персонаж будет выглядеть также.

Скриншот из чата с продюсером Level One

Снова вспомню ролик про японскую секту. Мы сделали для ролика про Аум Сенрикё несколько сцен с её главой Сёко Асахарой. Это был второй ролик на канале, и для второго раза это было конечно вау, но вы видите на коллаже ниже, что точь-в-точь Миджорни его не перерисовала. Такой получился мужичок по мотивам.

Пример, коллаж Сёко Асахара в жизни и по версии Миджорни

Но вот для ролика про Тоторо, который вышел спустя четыре месяца после официального запуска ютуб-канала, Яан уже значительно поднаторел и поглядите, как получилось. Пришлось помучаться с авторскими правами, но у нейронки получилось изобразить злого Тоторо. Нам нужен был такой образ по сюжету ролика.

Разогнавшись, мы даже выпускали игровые рекламные интеграции, полностью построенные на нейрогенерациях. Советую посмотреть пример ниже — на наш взгляд такой и должна быть реклама. Чтобы сотворить подобное, у Яана уходило в среднем 2-3 полных дня.

Пример, реклама на нейронках:

Выводы

Ну что, кто остался живой? Кто дочитал до этого места, тот молодец.

Итак, выводы из нашего приключения с нейросетками в продакшене длиною в 10 месяцев. Давайте снова обратимся к скриншоту, который я показывал после первой главы. Так я ставил задачу команде. А что в итоге?

Просто не будет. Чтобы вставки с нейросетями выглядели в видео прилично — надо заморочиться.

Обучающие материалы есть, но только тебе надо потратить время для того, чтобы все это дело найти. Например, у Миджорни есть своя обучающая библиотека, где они объясняют каждый параметр. Но она в веб-версии расположена не самым очевидным образом, сразу не найдёшь.

Самое смешное, я сейчас хожу на воркшопы Миджорини, они бьют себя в грудь и говорят, мол, «нигде, кроме как у нас, на воркшопах, вам нормально про Миджорни не расскажут». Я говорю, блин, я год пользовался Миджорни нормально, до того, как с вами познакомиться, и вроде как чему-то научился. Но да, если бы мы делали сейчас Level One с моими знаниями, было бы всё гораздо круче

Если вы ожидаете потыкаться один-два раза и сразу будет гениально, я вас расстрою, так не получится. У той же Миджорни, например, не самый интуитивный интерфейс.

Если вы нормальный английский не знаете — вы офигеете. Все учебные материалы — на английском, все промты надо писать — на английском. Каждое слово имеет определенный вес. И в зависимости от того, напишешь ты, там, книга голубая, потертая или любой другой синоним, ты будешь получать совершенно разные результаты. Чтобы не травмировать себе психику и не рейджить постоянно, лучше туда вообще не соваться

Если надо качество — можно хором — надо заморочиться.

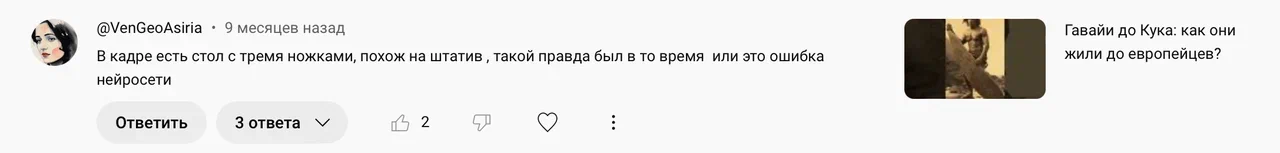

Мы работали на потоке, и со временем у нас уже не было сил исправлять за Миджорни шестипалые ладони или столы с тремя ножками. А иногда, честно говоря, ИИ так гармонично рисовала третью ногу кому-то, что это мы замечали уже после публикации.

Но когда есть время — отличный результат получить можно. Вот, например, посмотрите ниже на гифку, это фрагмент заставки для одного из сезонов на канале. Картинки сделаны в Миджорни, но их анимировал и поправил, где надо, профессиональный аниматор. На всё про всё ушла неделя.

ИИ не справляется со сложными темами. Помните я рассказывал про ролик про динозавров. Мы провели много часов в Дискорде, чтобы нарисовать приличных динозавров, но затем в комментариях нам знатно напихали любители достоверности. Мы не осуждаем этих людей, ибо в науке важна точность.

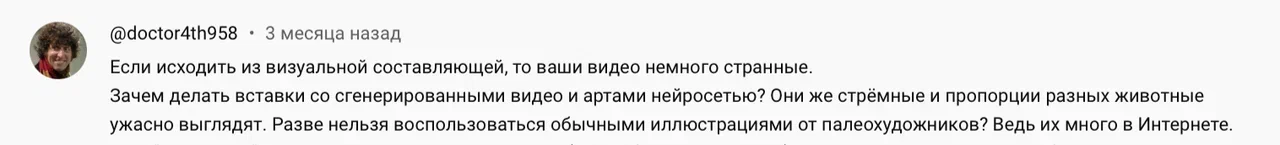

И важный момент — творчество нейросетей люди воспринимают противоречиво. После того, как спал эффект новизны, возник эффект зловещей долины. Негативные комментарии стали перевешивать позитивные.

Со временем мы стали делать меньше генераций. И из-за реакции в комментариях, и из-за того, что мы тупо устали.

Да, в каком-то обозримом будущем выйдет SORA. На фоне новостей про нее выскочили конкуренты типа Kling, Luma, Minimax и так далее. Да и Runway, которой мы активно использовали весь год, в июле 2024-го выпустил большое обновление.

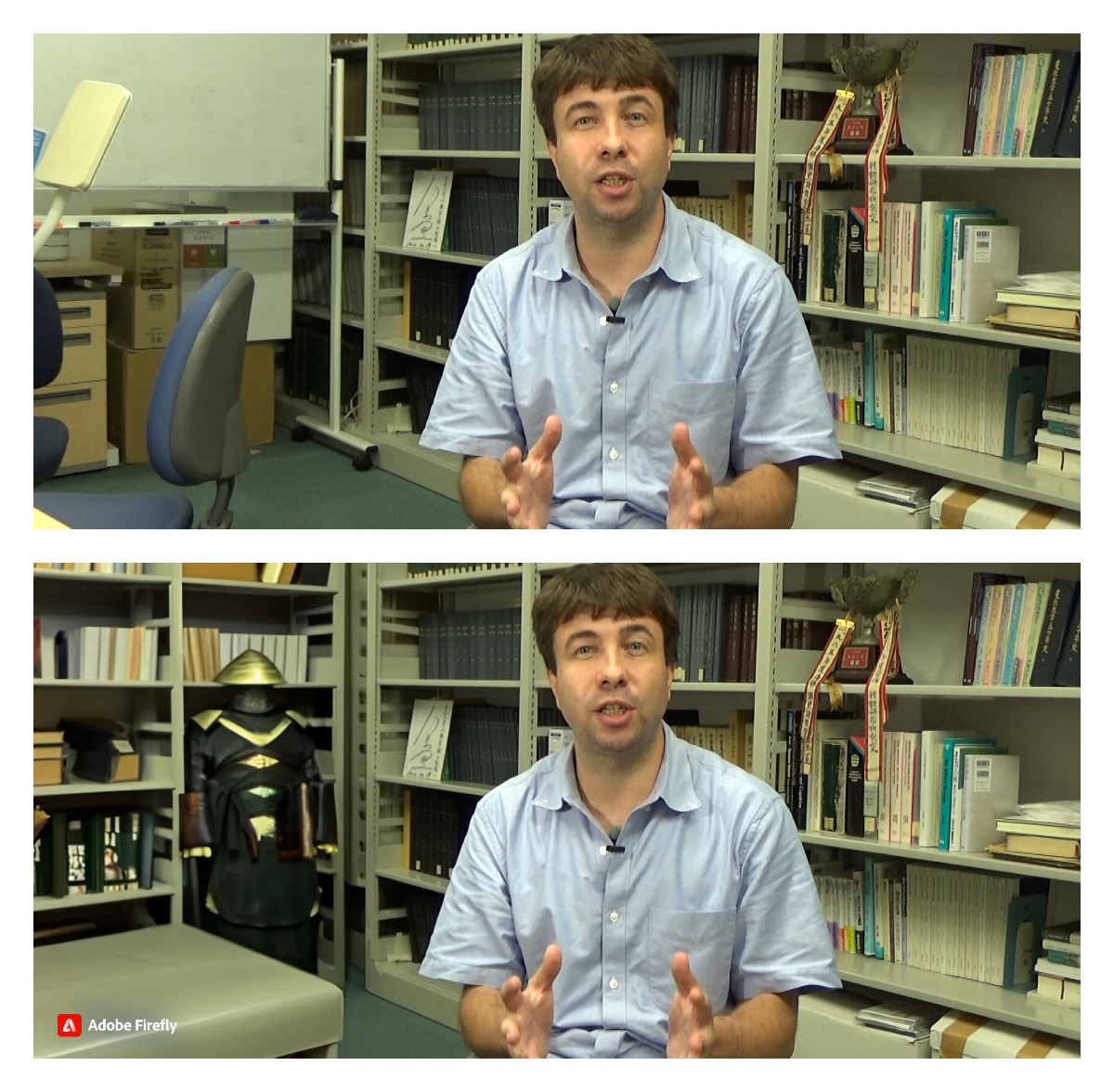

Но надо понимать что промо-материалы отличаются от реальности. Да, например Runway стал выдавать менее топорные и живые движения. Вот поглядите пример, вполне себе ничего. Два человека говорят и даже нормально шевелят ртами.

Год назад было так. Посмотрите как человек застрял в текстурах.

Но в то же время и сейчас Runway легко может выдать такое.

До времени, когда будет одна кнопка «сделай красиво» — ой как далеко. Пока нейросети просто хороший инструмент-помощник.

Например, в ситуации когда нужно что-то исправить, как на примере ниже. Относительно быстро (при умении) и прилично можно исправить фон на видео.

Пример, как Яан достроил японисту комнату, чтобы скрыть ее уродство:

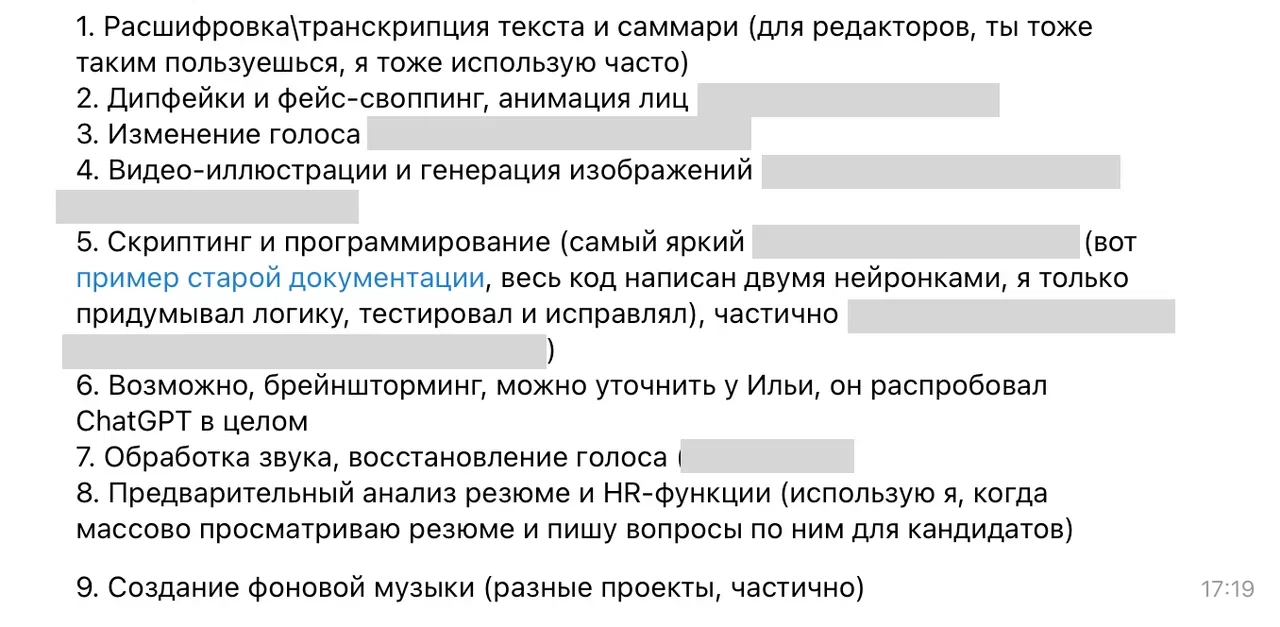

Я спросил у нашего главы продакшна, где он использует в работе нейросети. Список выглядит внушительно (скрыл уточнения по проектам в скриншоте, потому что некоторые под NDA). И это как раз задачи на подхвате, где можно сократить время на бытовуху и потратить на что-то более приятное. В этом нейросети хороши, и мы точно будем продолжать их внедрять в нашу работу дальше. И всем советуем, если вы ещё нет.

Но в каких-то задачах нейронки пока очень плохи. Это, например, реальные хорошие креативы. Живые настоящие идеи пока что побеждают роботов.

Спасибо вам, что прочли. Подробнее о разработке стратегии для канала Level One можете изучить по ссылке. Обращайтесь за консультацией, стратегией и за 100% органическим контентом для соцсетей, можно к нам — https://нидл.рф